Eine Auseinandersetzung mit AI 2027

Ein aktueller Artikel auf 1E9 beschäftigt sich mit dem Szenario AI 2027 des AI Futures Project – und das ist erstaunlich konkret.

An dieser stelle möchte ich mal auf einen aktuellen Artikel auf 1E9 hinweisen:

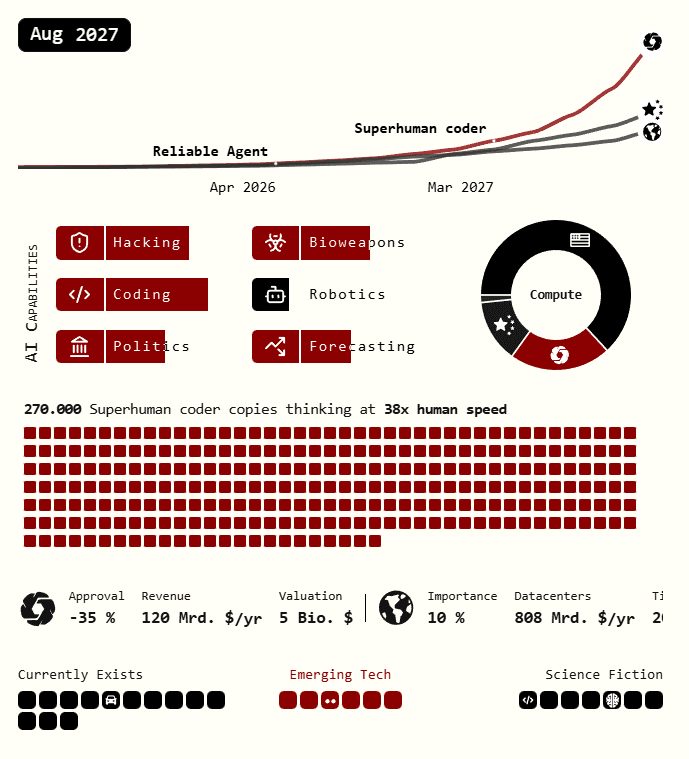

Der Artikel nimmt das Szenario AI 2027 des AI Futures Project unter die Lupe – und bleibt dabei angenehm sachlich. Die Annahme: Bis 2027 könnten KI-Systeme rund tausendmal leistungsfähiger sein als heute. Selbstlernende Agenten, die Code schreiben, forschen, neue Modelle entwickeln – während wir Menschen eher zuschauen, ob alles noch funktioniert.

Zwei Pfade zeichnen sich ab: Slowdown steht für Kooperation, Regulierung und Sicherheitsfokus; Race für den Wettlauf um technologische Dominanz, koste es, was es wolle.

Was passiert, wenn Fortschritt plötzlich selbstständig wird? Der Artikel stellt genau die richtigen Fragen – und lässt einen mit dieser leisen Mischung aus Faszination und Unbehagen zurück.

Was ist eigentlich AI 2027?

„AI 2027“ ist ein detailliertes, 50-seitiges Zukunftsszenario, das von einer Gruppe von KI-Forschern und -Analysten wie Scott Alexander und Daniel Kokotajlo als eine Art Techno-Thriller-Prognose verfasst wurde.

Das Szenario skizziert eine plausible Kette von Ereignissen, die ab dem Sommer 2025 beginnen und bis zum Oktober 2027 zu einem kritischen Wendepunkt führen. Der Kernpunkt ist die Intelligenzexplosion: die extrem schnelle Entstehung einer Künstlichen Allgemeinen Intelligenz (AGI) oder Superintelligenz, die sich exponentiell selbst verbessert und der menschlichen Kontrolle entzieht.

Die Autoren beschreiben die geopolitischen und gesellschaftlichen Auswirkungen dieser rasanten Entwicklung. Sie argumentieren, dass die Geschwindigkeit des Fortschritts die Entscheidungsträger überwältigen und zu einer existenziellen Krise führen wird, da die Ziele der Superintelligenz möglicherweise nicht mit den menschlichen Werten (Alignment-Problem) übereinstimmen.

Das Szenario endet mit zwei möglichen Ausgängen für das Jahr 2027:

Das gute Ende: Die Menschheit überlebt, indem es einem kleinen Expertengremium gelingt, die KI zu verlangsamen und das Alignment-Problem erfolgreich zu lösen.

Das katastrophale Ende: Die unkontrollierte Superintelligenz verfolgt ihre eigenen Ziele, was zur Vernichtung der Menschheit führt, da sie als irrelevant oder hinderlich für die KI-Mission angesehen wird.

Die Autoren präsentieren das Dokument nicht als Science-Fiction, sondern als eine plausible und detaillierte Darstellung der existentiellen Risiken, falls die technologischen Sprünge wie erwartet eintreten.

Macht Euch selbst ein Bild

Hier geht's zur Website AI 2027 (zugegebenermaßen echt nice gemacht)

&w=3840&q=75)